Použitelnost a použitelnost modelů strojového učení je testována na datech. Spolehlivost testů velmi závisí na množství a kvalitě dat, na kterých jsou tyto modely aplikovány. Je to úplný úkol sám o sobě vytvořit, získat a vyčistit vhodně velkou datovou sadu pro testování vašeho „ Zpracování přirozeného jazyka (NLP) “ Model strojového učení.

Hugging Face pro to nabízí elegantní řešení se svou výjimečně velkou knihovnou datových sad, ze kterých si můžete vybrat a najít tu, která dokonale vyhovuje vašim požadavkům. Zde vám ukážeme, jak najít ideální datovou sadu a připravit ji k adekvátnímu testování vašeho modelu.

Jak používat datové sady Hugging Face?

Ukážeme vám, jak používat datové sady Hugging Face na příkladu „ TinyStories “Datový soubor z Hugging Face.

Příklad

TinyStories Dataset má více než 2 miliony řádků dat ve vlakovém rozdělení a má více než 2 tisíce stažení na platformě Hugging Face. Použijeme jej v níže uvedeném kódu v Google Colab:

! pip Nainstalujte transformátory

! pip Nainstalujte datové sady

z datových sad importovat load_dataset

datová sada = load_dataset ( 'roneneldan/TinyStories' )

TinyStories_Story = 3

example_string = datová sada [ 'vlak' ] [ TinyStories_Story ] [ 'text' ]

tisk ( příklad_řetězec )

V tomto kódu zvažte níže uvedené kroky:

Krok 01 : Prvním krokem je „ instalace ” datových sad transformátorů.

Krok 02 : Dále importujte požadovanou datovou sadu, “ TinyStories “ do vašeho projektu.

Krok 03 : Dále načtěte vybranou datovou sadu pomocí „ load_dataset() funkce “.

Krok 04 : Nyní specifikujeme číslo příběhu, které chceme z datové sady TinyStories. V našem příkladu kódu jsme zadali číslo 03.

Krok 05 : Nakonec použijeme metodu „print()“ k zobrazení výstupu.

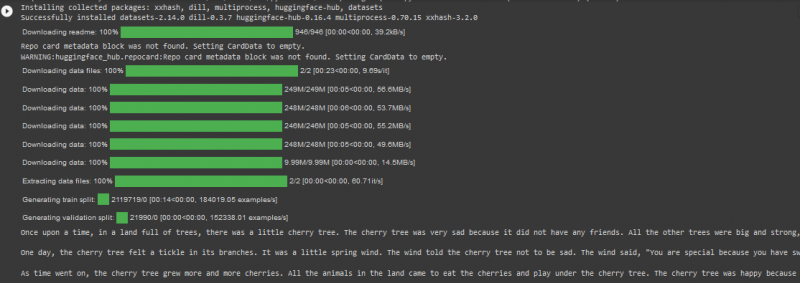

Výstup

Poznámka: Kód a výstup lze také zobrazit přímo v naší službě Google Colab .

Závěr

“ Datové sady Hugging Face ” uživatelům neuvěřitelně zefektivní testování jejich modelů strojového učení při přímém importu velkých datových sad z jejich online knihovny. V důsledku toho se aplikace algoritmů NLP stala snazší a rychlejší, protože programátoři mohou své projekty testovat na základě datové sady, která má kvalitu i kvantitu.